Марковские процессы примеры. Понятие о марковских случайных процессах. Многосвязный марковский процесс

Лекция 9

Марковские процессыЛекция 9

Марковские процессы

1

Марковские процессы

Марковские процессыСлучайный процесс, протекающий в системе, называется

марковским, если он обладает отсутствием последствия. Т.е.

если рассматривать текущее состояние процесса (t 0) - как

настоящее, совокупность возможных состояний { (s),s t} - как

прошлое, совокупность возможных состояний { (u),u t} - как

будущее, то для марковского процесса при фиксированном

настоящем будущее не зависит от прошлого, а определяется

лишь настоящим и не зависит от того, когда и как система

пришла в это состояние.

ХНУРЕ, каф. ПМ, лектор Кириченко Л.О.

«Теория вероятностей, математическая

статистика и случайные процессы»

2

Марковские процессы

Марковские процессыМарковские случайные процессы названы по имени выдающегося русского математика А.А.Маркова, впервые начавшего изучение вероятностной связи случайных величин

и создавшего теорию, которую можно назвать "динамикой

вероятностей". В дальнейшем основы этой теории явились

исходной базой общей теории случайных процессов, а также таких важных прикладных наук, как теория диффузионных процессов, теория надежности, теория массового обслуживания и т.д.

ХНУРЕ, каф. ПМ, лектор Кириченко Л.О.

«Теория вероятностей, математическая

статистика и случайные процессы»

3

Марков Андрей Андреевич Марков Андрей Андреевич Марков Андрей Андреевич

Марковские процессыМарков Андрей Андреевич

1856-1922

Русский математик.

Написал около 70 работ по

теории

чисел,

теории

приближения функций, теории

вероятностей. Существенно расширил сферу применения закона

больших чисел и центральной

предельной теоремы. Является

основоположником теории случайных процессов.

ХНУРЕ, каф. ПМ, лектор Кириченко Л.О.

«Теория вероятностей, математическая

статистика и случайные процессы»

4

Марковские процессы

Марковские процессыНа практике марковские процессы в чистом виде обычно

не встречаются. Но имеются процессы, для которых влиянием «предыстории» можно пренебречь, и при изучении

таких процессов можно применять марковские модели. В

настоящее время теория марковских процессов и ее приложения широко применяются в самых различных областях.

ХНУРЕ, каф. ПМ, лектор Кириченко Л.О.

«Теория вероятностей, математическая

статистика и случайные процессы»

5

Марковские процессы

Марковские процессыБиология: процессы рождения и гибели - популяции, мутации,

эпидемии.

Физика:

радиоактивные

распады,

теория

счетчиков

элементарных частиц, процессы диффузии.

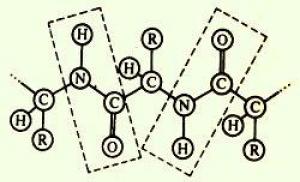

Химия:

теория

следов

в

ядерных

фотоэмульсиях,

вероятностные модели химической кинетики.

Images.jpg

Астрономия: теория флуктуационной

яркости млечного пути.

Теория массового обслуживания: телефонные станции,

ремонтные мастерские, билетные кассы, справочные бюро,

станочные и другие технологические системы, системы управления

гибких производственных систем, обработка информации серверами.

ХНУРЕ, каф. ПМ, лектор Кириченко Л.О.

«Теория вероятностей, математическая

статистика и случайные процессы»

6

Марковские процессы

Марковские процессыПусть в настоящий момент t0 система находится в

определенном состоянии S0. Мы знаем характеристики

состояния системы в настоящем и все, что было при t < t0

(предысторию процесса). Можем ли мы предсказать будущее,

т.е. что будет при t > t0?

В точности – нет, но какие-то вероятностные характеристики

процесса в будущем найти можно. Например, вероятность того,

что через некоторое время

система S окажется в состоянии

S1 или останется в состоянии S0 и т.д.

ХНУРЕ, каф. ПМ, лектор Кириченко Л.О.

«Теория вероятностей, математическая

статистика и случайные процессы»

7

Марковские процессы. Пример.

Марковские процессыМарковские процессы. Пример.

Система S – группа самолетов, участвующих в воздушном бою. Пусть x – количество

«красных» самолетов, y – количество «синих» самолетов. К моменту времени t0 количество сохранившихся (не сбитых) самолетов

соответственно – x0, y0.

Нас интересует вероятность того, что в момент времени

t 0 численный перевес будет на стороне «красных». Эта вероятность зависит от того, в каком состоянии находилась система

в момент времени t0, а не от того, когда и в какой последовательности погибали сбитые до момента t0 самолеты.

ХНУРЕ, каф. ПМ, лектор Кириченко Л.О.

«Теория вероятностей, математическая

статистика и случайные процессы»

8

Дискретные цепи Маркова

Марковские процессыДискретные цепи Маркова

Марковский процесс с конечным или счетным числом

состояний и моментов времени называется дискретной

цепью Маркова. Переходы из состояния в состояние возможны только в целочисленные моменты времени.

ХНУРЕ, каф. ПМ, лектор Кириченко Л.О.

«Теория вероятностей, математическая

статистика и случайные процессы»

9

10. Дискретные цепи Маркова. Пример

Марковские процессыПредположим,

что

речь

идет

о

последовательных бросаниях монеты при

игре "в орлянку"; монета бросается в

условные моменты времени t =0, 1, ... и на

каждом шаге игрок может выиграть ±1 с

одинаковой

вероятностью

1/2,

таким

образом в момент t его суммарный выигрыш есть случайная величина ξ(t) с возможными значениями j = 0, ±1, ... .

При условии, что ξ(t) = k, на следующем шаге выигрыш будет

уже равен ξ(t+1) = k ± 1, принимая значения j = k ± 1 c одинаковой вероятностью 1/2. Можно сказать, что здесь с соответствующей вероятностью происходит переход из состояния ξ(t) = k в состояние ξ(t+1) = k ± 1.

ХНУРЕ, каф. ПМ, лектор Кириченко Л.О.

«Теория вероятностей, математическая

статистика и случайные процессы»

10

11. Дискретные цепи Маркова

Марковские процессыДискретные цепи Маркова

Обобщая этот пример, можно представить себе систему со

счетным числом возможных состояний, которая с течением

дискретного времени t = 0, 1, ... случайно переходит из состояния в состояние.

Пусть ξ(t) есть ее положение в момент t в результате цепочки случайных переходов

ξ(0) -> ξ(1) -> ... -> ξ(t) -> ξ(t+1) ->...-> ... .

ХНУРЕ, каф. ПМ, лектор Кириченко Л.О.

«Теория вероятностей, математическая

статистика и случайные процессы»

11

12. Дискретные цепи Маркова

Марковские процессыДискретные цепи Маркова

При анализе случайных процессов с дискретными состояниями удобно пользоваться геометрической схемой – графом

состояний. Вершины графа – состояния системы. Дуги графа

– возможные переходы из состояния в состояние.

Игра «в орлянку».

ХНУРЕ, каф. ПМ, лектор Кириченко Л.О.

«Теория вероятностей, математическая

статистика и случайные процессы»

12

13. Дискретные цепи Маркова

Марковские процессыДискретные цепи Маркова

Обозначим все возможные состояния целыми i = 0, ±1, ...

Предположим, что при известном состоянии ξ(t) =i на следующем шаге система переходит в состояние ξ(t+1) = j с условной вероятностью

P{ (t 1) j (t) i}

независимо от ее поведения в прошлом, точнее, независимо

от цепочки переходов до момента t:

P{ (t 1) j (t) i; (t 1) it 1;...; (0) i0 }

P{ (t 1) j (t) i}

Это свойство называется марковским.

ХНУРЕ, каф. ПМ, лектор Кириченко Л.О.

«Теория вероятностей, математическая

статистика и случайные процессы»

13

14. Дискретные цепи Маркова

Марковские процессыДискретные цепи Маркова

Число

pij P{ (t 1) j (t) i}

называется вероятностью

перехода системы из состояния i в состояние j за один шаг в

момент времени t 1.

Если переходная вероятность не зависит от t , то цепь

Маркова называется однородной.

ХНУРЕ, каф. ПМ, лектор Кириченко Л.О.

«Теория вероятностей, математическая

статистика и случайные процессы»

14

15. Дискретные цепи Маркова

Марковские процессыДискретные цепи Маркова

Матрица P , элементами которой являются вероятности

перехода pij , называется переходной матрицей:

p11 ... p1n

P p 21 ... p 2n

p

n1 ... p nn

Она является стохастической, т.е.

pij 1 ;

i

ХНУРЕ, каф. ПМ, лектор Кириченко Л.О.

«Теория вероятностей, математическая

статистика и случайные процессы»

p ij 0 .

15

16. Дискретные цепи Маркова. Пример

Марковские процессыДискретные цепи Маркова. Пример

Матрица переходов для игры «в орлянку»

...

k 2

k 2

0

k 1

1/ 2

k

0

k 1

k

k 1

k 2

0

1/ 2

0

0

1/ 2

0

1/ 2

0

1/ 2

0

0

0

ХНУРЕ, каф. ПМ, лектор Кириченко Л.О.

«Теория вероятностей, математическая

статистика и случайные процессы»

...

k 1 k 2

0

0

0

1/ 2

0

1/ 2

...

0

0

1/ 2

0

16

17. Дискретные цепи Маркова. Пример

Марковские процессыДискретные цепи Маркова. Пример

Садовник в результате химического анализа почвы оценивает

ее состояние одним из трех чисел - хорошее (1), удовлетворительное (2) или плохое (3). В результате наблюдений на протяжении многих лет садовник заметил,

что продуктивность почвы в текущем

году зависит только от ее состояния в

предыдущем году. Поэтому вероятности

перехода почвы из одного состояния в

другое можно представить следующей

цепью Маркова с матрицей P1:

0.20 0.50 0.30

0.00 0.50 0.50

0.00 0.00 1.00

ХНУРЕ, каф. ПМ, лектор Кириченко Л.О.

«Теория вероятностей, математическая

статистика и случайные процессы»

17

18. Дискретные цепи Маркова. Пример

Марковские процессыДискретные цепи Маркова. Пример

Однако в результате агротехнических мероприятий садовник может изменить переходные вероятности в матрице P1.

Тогда матрица P1 заменится

на матрицу P2:

0.30 0.60 0.10

0.10 0.60 0.30

0.05 0.40 0.55

ХНУРЕ, каф. ПМ, лектор Кириченко Л.О.

«Теория вероятностей, математическая

статистика и случайные процессы»

18

19. Дискретные цепи Маркова

Марковские процессыДискретные цепи Маркова

Рассмотрим, как изменяются состояния процесса с течением времени. Будем рассматривать процесс в последовательные моменты времени, начиная с момента 0. Зададим начальное распределение вероятностей p(0) { p1 (0),..., pm (0)} , где m число состояний процесса, pi (0) - вероятность нахождения

процесса в состоянии i в начальный момент времени. Вероятность pi (n) называется безусловной вероятностью состояния

i в момент времени n 1.

Компоненты вектора p (n) показывают, какие из возможных состояний цепи в момент времени n являются наиболее

вероятными.

m

ХНУРЕ, каф. ПМ, лектор Кириченко Л.О.

«Теория вероятностей, математическая

статистика и случайные процессы»

pk (n) 1

k 1

19

20. Дискретные цепи Маркова

Марковские процессыДискретные цепи Маркова

Знание последовательности { p (n)} при n 1,... позволяет составить представление о поведении системы во времени.

В системе с 3-мя состояниями

p11 p12 p13

P p21

p

31

p22

p32

p23

p33

p2 (1) p1 (0) p12 p2 (0) p22 p3 (0) p32

p2 (n 1) p1 (n) p12 p2 (n) p22 p3 (n) p32

В общем случае:

p j (1) pk (0) pkj

p j (n 1) pk (n) pkj

k

ХНУРЕ, каф. ПМ, лектор Кириченко Л.О.

«Теория вероятностей, математическая

статистика и случайные процессы»

k

p(n 1) p(n) P

20

21. Дискретные цепи Маркова. Пример

Марковские процессыДискретные цепи Маркова. Пример

Матрица

0.20 0.50 0.30

0.00 0.50 0.50

0.00 0.00 1.00

Шаг

{ p (n)}

n

0

1, 0, 0

n

1

0.2 , 0.5 , 0.3

n

2

0.04 , 0.35 , 0.61

n

3

0.008 , 0.195 , 0.797

n

4

0.0016 , 0.1015 , 0.8969

ХНУРЕ, каф. ПМ, лектор Кириченко Л.О.

«Теория вероятностей, математическая

статистика и случайные процессы»

21

22. Дискретные цепи Маркова

Марковские процессыДискретные цепи Маркова

n

Матрица перехода за n шагов P(n) P .

0.20 0.50 0.30

0.00 0.50 0.50

0.00 0.00 1.00

p(2) p(0) P

2

p (2)

P(2) P 2

1, 0, 0

0.0016

0.

0.

0.0016

0.

0.

0.1015

0.0625

0.

0.1015

0.0625

0.

0.8969

0.9375

1.

0.8969

0.9375

1.

0.04 , 0.35 , 0.61

ХНУРЕ, каф. ПМ, лектор Кириченко Л.О.

«Теория вероятностей, математическая

статистика и случайные процессы»

22

23. Дискретные цепи Маркова

Марковские процессыДискретные цепи Маркова

Как ведут себя марковские цепи при n ?

Для однородной марковской цепи при определенных условиях выполняется следующее свойство: p (n) при n .

Вероятности 0 не зависят от начального распределения

p(0) , а определяются только матрицей P . В этом случае называется стационарным распределением, а сама цепь – эргодической. Свойство эргодичности означает, что по мере увеличения n

вероятность состояний практически перестаёт изменяться, а система переходит в стабильный режим функционирования.

i

ХНУРЕ, каф. ПМ, лектор Кириченко Л.О.

«Теория вероятностей, математическая

статистика и случайные процессы»

23

24. Дискретные цепи Маркова. Пример

Марковские процессыДискретные цепи Маркова. Пример

0.20 0.50 0.30

0.00 0.50 0.50

0.00 0.00 1.00

0 0 1

P() 0 0 1

0 0 1

ХНУРЕ, каф. ПМ, лектор Кириченко Л.О.

«Теория вероятностей, математическая

статистика и случайные процессы»

p () (0,0,1)

24

25. Дискретные цепи Маркова. Пример

Марковские процессыДискретные цепи Маркова. Пример

0.30 0.60 0.10

0.10 0.60 0.30

0.05 0.40 0.55

0.1017 0.5254 0.3729

P() 0.1017 0.5254 0.3729

0.1017 0.5254 0.3729

p () (0.1017,0.5254,0.3729)

ХНУРЕ, каф. ПМ, лектор Кириченко Л.О.

«Теория вероятностей, математическая

статистика и случайные процессы»

25

26. Марковские процессы с непрерывным временем

Марковские процессыПроцесс называется процессом с непрерывным временем, если

моменты возможных переходов из состояния в состояние не фиксированы заранее, а неопределенны, случайны и могут произойти

в любой момент.

Пример. Технологическая система S состоит из двух устройств,

каждое из которых в случайный момент времени может выйти из

строя, после чего мгновенно начинается ремонт узла, тоже продолжающийся заранее неизвестное, случайное время.

Возможны следующие состояния системы:

S0 - оба устройства исправны;

S1 - первое устройство ремонтируется, второе исправно;

S2 - второе устройство ремонтируется, первое исправно;

S3 - оба устройства ремонтируются.

ХНУРЕ, каф. ПМ, лектор Кириченко Л.О.

«Теория вероятностей, математическая

статистика и случайные процессы»

26

27. Марковские процессы с непрерывным временем

Марковские процессыМарковские процессы с непрерывным временем

Переходы системы S из состояния в состояние происходят

практически мгновенно, в случайные моменты выхода из строя

того или иного устройства или

окончания ремонта.

Вероятностью одновременного

выхода из строя обоих устройств

можно пренебречь.

ХНУРЕ, каф. ПМ, лектор Кириченко Л.О.

«Теория вероятностей, математическая

статистика и случайные процессы»

27

28. Потоки событий

Марковские процессыПотоки событий

Поток событий – последовательность однородных событий, следующих одно за другим в какие-то случайные моменты времени.

– это среднее число событий,

Интенсивность потока событий

приходящееся на единицу времени.

ХНУРЕ, каф. ПМ, лектор Кириченко Л.О.

«Теория вероятностей, математическая

статистика и случайные процессы»

28

29. Потоки событий

Марковские процессыПотоки событий

Поток событий называется стационарным, если его вероятностные характеристики не зависят от времени.

В частности, интенсивность

стационарного потока постоянна. Поток событий неизбежно имеет сгущения или разрежения, но они не носят закономерного характера, и среднее число событий, приходящееся на единицу времени, постоянно и от времени не зависит.

ХНУРЕ, каф. ПМ, лектор Кириченко Л.О.

«Теория вероятностей, математическая

статистика и случайные процессы»

29

30. Потоки событий

Марковские процессыПотоки событий

Поток событий называется потоком без последствий, если для

любых двух непересекающихся участков времени и число событий, попадающих на один из них, не зависит от того, сколько событий попало на другой. Другими словами, это означает, что события, образующие поток, появляются в те или иные моменты

времени независимо друг от друга и вызваны каждое своими собственными причинами.

Поток событий называется ординарным, если вероятность появления на элементарном участке t двух и более событий пренебрежимо мала по сравнению с вероятностью появления одного

события, т.е. события в нем появляются поодиночке, а не группами по нескольку сразу

ХНУРЕ, каф. ПМ, лектор Кириченко Л.О.

«Теория вероятностей, математическая

статистика и случайные процессы»

30

31. Потоки событий

Марковские процессыПотоки событий

Поток событий называется простейшим (или стационарным пуассоновским), если он обладает сразу тремя свойствами: 1) стационарен, 2) ординарен, 3) не имеет последствий.

Простейший поток имеет наиболее простое математическое описание. Он играет среди потоков такую же особую

роль, как и закон нормального распределения среди других

законов распределения. А именно, при наложении достаточно большого числа независимых, стационарных и ординарных

потоков (сравнимых между собой по интенсивности) получается поток, близкий к простейшему.

ХНУРЕ, каф. ПМ, лектор Кириченко Л.О.

«Теория вероятностей, математическая

статистика и случайные процессы»

31

32. Потоки событий

Марковские процессыПотоки событий

Для простейшего потока с интенсивностью

интервал

времени T между соседними событиями имеет показательное

распределение с плотностью

p(x) e x , x 0 .

Для случайной величины T, имеющей показательное распределение, математическое ожидание есть величина, обратная параметру.

ХНУРЕ, каф. ПМ, лектор Кириченко Л.О.

«Теория вероятностей, математическая

статистика и случайные процессы»

32

33. Марковские процессы с непрерывным временем

Марковские процессыМарковские процессы с непрерывным временем

Рассматривая процессы с дискретными состояниями и непрерывным временем, можно считать, что все переходы системы S из состояния в состояние происходят под действием

простейших потоков событий (потоков вызовов, потоков отказов, потоков восстановлений и т.д.).

Если все потоки событий, переводящие систему S из состояния в состояние простейшие, то процесс, протекающий в

системе, будет марковским.

ХНУРЕ, каф. ПМ, лектор Кириченко Л.О.

«Теория вероятностей, математическая

статистика и случайные процессы»

33

34. Марковские процессы с непрерывным временем

Марковские процессыМарковские процессы с непрерывным временем

Пусть на систему, находящуюся в состоянии, действует

простейший поток событий. Как только появится первое событие этого потока, происходит «перескок» системы из состояния

в состояние.

- интенсивность потока событий, переводящий систему

из состояния

ХНУРЕ, каф. ПМ, лектор Кириченко Л.О.

«Теория вероятностей, математическая

статистика и случайные процессы»

в

.

34

35. Марковские процессы с непрерывным временем

Марковские процессыМарковские процессы с непрерывным временем

Пусть рассматриваемая система S имеет

возможных состояний

. Вероятность p ij (t) является вероятностью перехода из состояния i в состояние j за время t.

Вероятность i - го состояния

- это вероятность того,

что в момент времени t система будет находиться в состоянии

. Очевидно, что для любого момента времени сумма

всех вероятностей состояний равна единице:

ХНУРЕ, каф. ПМ, лектор Кириченко Л.О.

«Теория вероятностей, математическая

статистика и случайные процессы»

35

36. Марковские процессы с непрерывным временем

Марковские процессыМарковские процессы с непрерывным временем

Для нахождения всех вероятностей состояний

как

функций времени составляются и решаются дифференциальные уравнения Колмогорова – особого вида уравнения, в которых неизвестными функциями являются вероятности состояний.

Для переходных вероятностей:

p ij (t) p ik (t) kj

k

Для безусловных вероятностей:

p j (t) p k (t) kj

k

ХНУРЕ, каф. ПМ, лектор Кириченко Л.О.

«Теория вероятностей, математическая

статистика и случайные процессы»

36

37. Колмогоров Андрей Николаевич

Марковские процессыКолмогоров Андрей Николаевич

1903-1987

Великий русский

математик.

ХНУРЕ, каф. ПМ, лектор Кириченко Л.О.

«Теория вероятностей, математическая

статистика и случайные процессы»

37

38. Марковские процессы с непрерывным временем

Марковские процессыМарковские процессы с непрерывным временем

- интенсивности потока отказов;

- интенсивности потока восстановлений.

Пусть система находится в состоянии

S0. В состояние S1 ее переводит поток

отказов первого устройства. Его интенсивность равна

где

- среднее время безотказной работы устройства.

Из состояния S1 в S0 систему переводит поток восстановлений

первого устройства. Его интенсивность равна

где

- среднее время ремонта первого станка.

Аналогично вычисляются интенсивности потоков событий, переводящих систему по всем дугам графа.

ХНУРЕ, каф. ПМ, лектор Кириченко Л.О.

«Теория вероятностей, математическая

статистика и случайные процессы»

38

39. Системы массового обслуживания

Марковские процессыПримеры систем массового обслуживания (СМО): телефонные станции, ремонтные мастерские,

билетные

кассы,

справочные

бюро,

станочные и другие технологические системы,

системы

управления

гибких

производственных систем,

обработка информации серверами и т.д.

ХНУРЕ, каф. ПМ, лектор Кириченко Л.О.

«Теория вероятностей, математическая

статистика и случайные процессы»

39

40. Системы массового обслуживания

Марковские процессыСистемы массового обслуживания

СМО состоит из какого – то количества обслуживающих

единиц, которые называются каналами обслуживания (это

станки, роботы, линии связи, кассиры и т.д.). Всякая СМО

предназначена для обслуживания потока заявок (требований), поступающих в случайные моменты времени.

Обслуживание заявки продолжается случайное время, после чего канал освобождается и готов к приему следующей

заявки.

ХНУРЕ, каф. ПМ, лектор Кириченко Л.О.

«Теория вероятностей, математическая

статистика и случайные процессы»

40

41. Системы массового обслуживания

Марковские процессыСистемы массового обслуживания

Процесс работы СМО – случайный процесс с дискретными

состояниями и непрерывным временем. Состояние СМО меняется скачком в моменты появления каких - то событий

(прихода новой заявки, окончания обслуживания, момента,

когда заявка, которой надоело ждать, покидает очередь).

ХНУРЕ, каф. ПМ, лектор Кириченко Л.О.

«Теория вероятностей, математическая

статистика и случайные процессы»

41

42. Системы массового обслуживания

Марковские процессыСистемы массового обслуживания

Классификация систем массового обслуживания

1. СМО с отказами;

2. СМО с очередью.

В СМО с отказами заявка, поступившая в момент, когда все каналы заняты, получает отказ, покидает СМО и в дальнейшем не

обслуживается.

В СМО с очередью заявка, пришедшая в момент, когда все каналы заняты, не уходит, а становится в очередь и ожидает возможности быть обслуженной.

СМО с очередями подразделяются на разные виды в зависимости

от того, как организована очередь – ограничена или не ограничена. Ограничения могут касаться как длины очереди, так и времени

ожидания, «дисциплины обслуживания».

ХНУРЕ, каф. ПМ, лектор Кириченко Л.О.

«Теория вероятностей, математическая

статистика и случайные процессы»

42

43. Системы массового обслуживания

Марковские процессыСистемы массового обслуживания

Предмет теории массового обслуживания – построение

математических моделей, связывающих заданные условия

работы СМО (число каналов, их производительность, правила

работы, характер потока заявок) с интересующими нас характеристиками – показателями эффективности СМО. Эти показатели описывают способность СМО справляться с потоком

заявок. Ими могут быть: среднее число заявок, обслуживаемых СМО в единицу времени; среднее число занятых каналов; среднее число заявок в очереди; среднее время ожидания обслуживания и т.д.

ХНУРЕ, каф. ПМ, лектор Кириченко Л.О.

«Теория вероятностей, математическая

статистика и случайные процессы»

43

44.

СПАСИБОЗА ВНИМАНИЕ!!!

44

45. Построить граф переходов

Марковские процессыПостроить граф переходов

0.30

0.70

0.0

0.10

0.60

0.30

0.50

0.50

0.0

ХНУРЕ, каф. ПМ, лектор Кириченко Л.О.

«Теория вероятностей, математическая

статистика и случайные процессы»

В этом параграфе мы используем метод марковских процессов для отыскания оптимального демодулятора. Наше изложение носит поверхностный характер, поэтому для более подробного рассмотрения интересующимся читателям следует обратиться к дополнительным источникам (в частности, ). И на этот раз будем предполагать, что сообщение является гауссовым случайным процессом с конечным представлением в переменных состояния, т. е.

где белый гауссов случайный процесс с ковариационной функцией

Хотя мы и не используем этот факт по ходу изложения, следует указать, что изложенную в данном параграфе процедуру можно также выполнить, когда уравнение состояния и уравнение наблюдения нелинейны и имеют форму

Отметим, что при некоторых ограничениях, налагаемых на является векторным марковским процессом, который необязательно является гауссовым. Ни один из ранее рассмотренных методов не позволяет решать задачи с сообщениями этого класса. Большинство результатов, которые будут получены в этом параграфе, можно также получить и для более общего процесса, описываемого уравнениями (78) и (79).

Вернемся теперь к модели в виде случайного процесса, описываемого соотношениями Ради простоты записи будем рассматривать сообщение, которое является скалярным гауссовым марковским процессом и которым передаваемое колебание модулировано каким-либо безынерционным видом модуляции. Принятое колебание записывается в виде

Процесс сообщения удовлетворяет дифференциальному уравнению первого порядка

Таким образом, при любых конечных сообщение является стационарным процессом и имеет спектр Баттерворта первого порядка. Далее, ввиду того, что марковский процесс первого порядка, его плотность вероятности при отсутствии всяких наблюдений удовлетворяет уравнению Фоккера-Планка [см. (3.79)]

Однако, поскольку наблюдалось в течение интервала времени интересующая нас плотность вероятности является не безусловной плотностью, а плотностью, обусловленной наблюдаемым колебанием Обозначим эту плотность через

Заметим, что (86) есть плотность вероятности одной случайной величины (величины, обозначающей значение а в момент времени обусловленной наблюдаемым колебанием, и представляет собой четко определенную характеристику. Можно показать , что эта плотность вероятности удовлетворяет уравнению

где математические ожидания берутся по плотности Если формально ввести производную

![]()

то (87) можно формально записать в виде дифференциального уравнения

Соотношение между апостериорной плотностью и оценкой по минимуму среднеквадратической ошибки хорошо известно. Оценка по минимуму среднеквадратической ошибки есть условное среднее апостериорной плотности (см. стр. 73 первого тома), т. е.

Умножая обе части (89) на А, интегрируя по и учитывая соответствующие условия на концах интервала, получаем (см. задачу 7.2.2)

Заметим, что (91) все еще содержит математическое ожидание по Как и следовало ожидать, это уравнение не решается для общего случая модуляции. В случае линейных методов модуляции легко показать (например, 18] или задача 7.2.1), что оно сводится к Для многих задач нелинейной модуляции добиться успеха можно путем разложения в ряд различных членов уравнения (91). Тогда, если предположить, что ошибка оценивания мала и наложить некоторые условия на моменты высших порядков, можно пренебречь членами второго и более высоких порядков и получить следующее приближенное уравнение (подробный вывод дан в гл. 4 книги ):

где через обозначена приближенная оценка по минимуму среднеквадратической ошибки. Функция есть приближенный условный [по средний квадрат ошибки, который удовлетворяет дифференциальному уравнению

с граничным условием

Заметим, что уравнение оценки (92) и дисперсионное уравнение (93) являются связанными. Заметим далее, что условная среднеквадратическая ошибка [т. е. ошибка при условии, что принято Приближения, которые необходимо допустить, чтобы получить справедливы, когда ошибка мала.

Мы видим, что уравнение (92) можно реализовать в виде структурной схемы, показанной на рис. 7.3. Эта реализация очень сходна со структурой устройства оценки по максимуму апостериорной вероятности, синтезированного в гл. 2, с той лишь разницей, что теперь фильтр в петле является автоматически реализуемым. Недостаток этой реализации - наличие связи между петлями.

В случае угловой модуляции можно показать, что этой связью обычно можно пренебречь. Например, при фазовой модуляции

Предполагается, что много больше наивысшей частоты в спектре сообщения и что система находится в статистически стационарном состоянии. В этом случае показано , что

![]()

удовлетворяет дисперсионному уравнению при подстановке

Для марковского процесса первого порядка это уравнение имеет вид

Структурная схема приемника показана на рис. 7.4. Эта структура точно совпадает с реализуемой частью приближенного приемника по максимуму апостериорной вероятности, который был синтезирован ранее (см. задачу в (68) можно теперь интерпретировать как приближенную условную среднеквадратическую ошибку.

Рис. 7.4. Оптимальный приемник: фазовая модуляция, сообщение со спектром Баттерворта первого порядка.

Ввиду того, что большая часть подробностей вывода была опущена, важно обратить внимание на ограничения полученного результата. Дифференциальное уравнение (91), определяющее условное среднее, является точным. Однако приближения, связанные с получением (92)-(93), соответствуют линеаризирующему допущению. Поэтому наш результат является приближенной оценкой по минимуму среднеквадратической ошибки, соответствующей первому члену разложения в ряд точной оценки. Чтобы получить лучшее приближение, можно удержать большее число членов разложения (см., например, ). Трудность, связанная с этой процедурой, заключается в том, что двучленное приближение является уже столь сложным, что, вероятно, не представляет практического интереса.

Под случайным процессом понимают изменение во времени состояний некоторой физической системы заранее неизвестным случайным образом. При этом под физической системой будем понимать любое техническое устройство, группу устройств, предприятие, отрасль, биологическую систему и т.д.

Случайный процесс протекающий в системе называется Марковским – если для любого момента времени ,вероятностные характеристики процесса в будущем (t > ) зависят только от его состояния в данный момент времени (в настоящем ) и не зависят от того, когда и как система пришла в это состояние в прошлом .(Например, счетчик Гейгера, регистрирующий число космических частиц).

Марковские процессы принято делить на 3 вида:

1. Марковская цепь – процесс, состояния которого дискретны (т.е. их можно перенумеровать), и время, по которому он рассматривается, также дискретно (т.е. процесс может менять свои состояния только в определенные моменты времени). Такой процесс идет (изменяется) по шагам (иначе - по тактам).

2. Дискретный марковский процесс – множество состояний дискретно (можно перечислить), а время непрерывно (переход из одного состояния в другое – в любой момент времени).

3. Непрерывный марковский процесс – множество состояний и время -непрерывные.

На практике Марковские процессы в чистом виде встречаются не часто. Однако нередко приходится иметь место с процессами, для которых влиянием предыстории можно пренебречь. Кроме того, если все параметры из «прошлого»,от которых зависит «будущее» включить в состоянии системы в «настоящем», то ее также можно рассматривать как Марковскую. Однако это часто приводит к значительному росту числа учитываемых переменных и невозможности получить решение задачи.

В исследование операций большое значение занимают так называемые Марковские случайные процессы с дискретными состояниями и непрерывным временем .

Процесс называется процессом с дискретными состояниями , если все его возможные состояния , ,... можно заранее перечислить (перенумеровать). Переход системы из состояния в состояние переходит практически мгновенно –скачком.

Процесс называется процессом с непрерывным временем , если моменты перехода из состояния в состояние могут принимать любые случайные значения на временной оси.

Например : Техническое устройство S состоит из двух узлов , каждый из которых в случайный момент времени может выйти из строя (отказать ). После этого мгновенно начинается ремонт узла (восстановление ),который продолжается случайное время.

Возможны следующие состояния системы:

Оба узла исправны;

Первый узел ремонтируется,второй исправен.

– второй узел ремонтируется,первый исправен

Оба узла ремонтируются.

Переход системы из состояния в состояние происходит в случайные моменты времени практически мгновенно. Состояния системы и связь между ними удобно отобразить с помощью графа состояний .

Состояния

Переходы

Переходы и отсутствуют т.к. отказы и восстановления элементов происходят независимо и случайно и вероятность одновременного выхода из строя (восстановления) двух элементов бесконечно мала и ею можно пренебречь.

Если все потоки событий, переводящие систему S из состояния в состояние –простейшие , то процесс, протекающий в такой системе будетМарковским . Это обуславливается тем, что простейший поток не обладает последействием, т.е. в нем «будущее» не зависит от «прошлого» и, кроме того, он обладает свойством ординарности – вероятность одновременного появления двух и более событий бесконечно мала, т.е невозможен переход из состояния в состояние, минуя несколько промежуточных состояний.

Для наглядности на графе состояний удобно у каждой стрелки перехода проставить интенсивность того потока событий, который переводит систему из состояния в состояние по данной стрелке ( -интенсивность потока событий, переводящего систему из состояния в . Такой граф называется размеченным.

![]()

![]()

Используя размеченный граф состояний системы можно построить математическую модель данного процесса.

Рассмотрим переходы системы из некоторого состояния в предыдущее или последующее . Фрагмент графа состояний в этом случае будет выглядеть следующим образом:

Пусть система в момент времени t находится в состоянии .

Обозначим (t)- вероятность i-ого состояния системы – вероятность того, что система в момент времени t находится в состоянии . Для любого момента времени t справедливо =1.

Определим вероятность того, что и в момент времени t+∆t система будет находиться в состоянии . Это может быть в следующих случаях:

1) и за время ∆ t из него не вышла. Это означает, что за время ∆t не возникло события, переводящего систему в состояние (поток с интенсивностью ) или события, переводящего её в состояние (поток с интенсивностью ). Определим вероятность этого при малых ∆t.

При экспоненциальном законе распределения времени между двумя соседними требованиями, соответствующему простейшему потоку событий вероятность того, что на интервале времени ∆t не возникнет ни одного требования в потоке с интенсивностью λ 1 будет равна

Разлагая функцию f(t) в ряд Тейлора (t>0) получим (для t=∆t)

f(∆t)=f(0)+ (0)* ∆t + *∆ + *∆ +…=

= +(-l) *∆t+ (∆ + *(∆ +…»1-l*∆t при ∆t®0

Аналогично для потока с интенсивностью λ 2 получим

![]() .

.

Вероятность, что на интервале времени ∆t (при ∆t®0) не возникнет ни одного требования будет равна

(∆t)/ = (∆t/ * (∆t/ = (1- *∆t)(1- *∆t) =

1 - - *∆t + ![]() 1 - (

+

)*∆t + б.м.

1 - (

+

)*∆t + б.м.

Таким образом, вероятность того, что система за время ∆t не вышла из состояния , при малых ∆t будет равна

P( / )=1 – ( + )* ∆t

2) Система находилась в состоянии S i -1 и за время перешла в состояние S i . То есть в потоке с интенсивностью возникло хотя бы одно событие. Вероятность этого равна для простейшего потока с интенсивностью λ будет

Для нашего случая вероятность такого перехода будет равна

3)Система находилась в состоянии и за время ∆tперешла в состояние . Вероятность этого будет

Тогда вероятность, что система в момент времени (t+∆t) будет в состоянии S i равна

![]()

Вычтем из обеих частей P i (t), разделим на ∆tи, перейдя к пределу, при ∆t→0, получим

Подставив соответствующие значения интенсивностей переходов из состояний в состояния, получим систему дифференциальных уравнений, описывающих изменение вероятностей состояний системы как функций времени.

Данные уравнения называются уравнениями Колмогорова-Чепмена для дискретного марковского процесса.

Задав начальные условия (например, P 0 (t=0)=1,P i (t=0)=0 i≠0) и решив их, получим выражения для вероятностей состояния системы как функций времени. Аналитические решения достаточно просто получить, если число уравнений ≤ 2,3. Если их больше, то обычно решают уравнения численно- на ЭВМ (например методом Рунге-Кутта).

В теории случайных процессов доказано , что если число n состояний системы конечно и из каждого из них можно (за конечное число шагов) перейти в любое другое, то существует предел , к которому стремятся вероятности при t→ . Такие вероятности называются финальными вероятностями состояний, а установившийся режим - стационарным режимом функционирования системы.

Так как в стационарном режиме все ![]() , следовательно, все =0. Приравняв в системе уравнений левые части 0 и, дополнив их уравнением =1, получим систему линейных алгебраических уравнений, решив которую найдём значения финальных вероятностей.

, следовательно, все =0. Приравняв в системе уравнений левые части 0 и, дополнив их уравнением =1, получим систему линейных алгебраических уравнений, решив которую найдём значения финальных вероятностей.

Пример. Пусть в нашей системе интенсивности отказов и восстановления элементов следующие

Отказы

1эл: ![]()

2эл: ![]()

Ремонт

1эл: ![]()

2эл: ![]()

P 0 +P 1 +P 2 +P 3 =1

0=-(1+2)P 0 +2P 1 +3 P 2

0=-(2+2)P 1 +1P 0 +3P 3

0=-(1+3)P 2 +2P 0 +2P 3

0=-(2+3)P 3 +2P 1 +1P 2

Решив данную систему, получим

P 0 =6/15=0.4; P 1 =3/15=0.2; P 2 =4/15=0.27; P 3 =2/15≈0.13.

Т.е. в стационарном состоянии система в среднем

40% находится в состоянии S 0 (оба узла исправны),

20%- в состоянии S 1 (1-й эл-т ремонтируется, 2-й исправен),

27%- в состоянии S 2 (2-й эл-тремонтируется, 1исправен),

13%- в состоянии S 3 – оба эл-та в ремонте.

Знание финальных вероятностей позволяет оценить среднюю эффективность работы системы и загрузку службы ремонта.

Пусть система в состоянии S 0 приносит доход 8 усл.ед. в единицу времени; в состоянии S 1 -доход 3 усл.ед.; в состоянии S 2 - доход 5;в состоянии S 3 -доход=0

Стоимость ремонта в единицу времени для эл-та 1- 1(S 1, S 3) усл.ед., эл-та 2- (S 2, S 3) 2 усл.ед. Тогда в стационарном режиме:

Доход системы в единицу времени будет:

W дох =8P 0 +3P 1 +5P 2 +0P 3 =8·0.4+3·0.2+5·0.27+0·0.13=5.15 усл.ед.

Стоимость ремонта в ед. времени:

W рем =0P 0 +1P 1 +2P 2 +(1+2)P 3 =0·0.4+1·0.2+2·0.27+3·0.13=1.39 усл.ед.

Прибыль в единицу времени

W= W дох -W рем =5.15-1.39=3.76 усл.ед

Проведя определённые расходы можно изменить интенсивности λи μ и, соответственно, эффективность системы. Целесообразность таких расходов можно оценить, проведя пересчёт P i . и показателей эффективности системы.

Марковские случайные процессы.

Предположим, что нам необходимо изучить некоторую «физическая систему» S (процесс функционирования которой можно описать явным образом), которая может с течением времени изменять свое состояние (переходит из одного состояния в другое) заранее неизвестным, случайным образом. Под «физической системой» можно понимать что угодно: техническое устройство, группу таких устройств, предприятие, отрасль промышленности, живой организм, популяцию и так далее.

Полагаем, что исследуемая система S может быть описана некоторым множеством возможных, заранее известных состояний системы S i , которые можно определить исходя из «физической природы» исследуемого процесса функционирования системы, т.е. .

- i -тое состояние системы зависит от k параметров.

|

В реальной ситуации состояние системы может зависеть от причинно-следственных связей между состояниями и процессами, протекающими в системе. То есть на характер поведения системы накладывается отпечаток «предыстории» характера поведения системы и набор некоторых случайных факторов (внешних или внутренних процессов-возмущений). Мы сталкиваемся с множеством «предполагаемых сценариев» протекания процесса функционирования системы. И сам «выбор» доминирующего «сценария поведения» (как поведет себя исследуемая система) носит случайный характер.

Следует учесть, что переход из состояния S i в состояние S j носит стохастический характер. Функционирование системы начинаем рассматривать с начального состояния S 0 , которому соответствует момент времени t 0 . То есть, то, что было с системой до момента времени t 0 , относится к «прошлому оной», к предыстории.

Определение: Случайный процесс, протекающий в системе, называется марковским, если для любого момента времени t 0 вероятностные характеристики процесса в будущем зависят только от его состояния в данный момент t 0 и не зависят от того, когда и как система пришла в это состояние.

Полагаем, что состояние системы описывается функцией S (t ), аргумент этой функции, - время t непрерывно, известны моменты времени перехода системы из одного состояния в другое t : t 1 <t 2 < … <t n . Причем переход из одного состояния в другое происходит «скачком», практически мгновенно.

Пришли к тому, что процессу функционирования системы ставится в соответствие цепь дискретных состояний: S 1 ®S 2 ® … ®S n-1 ®S n (последовательный переход из одного состояния в другое, без «перескакивания» через какое-либо состояние). То есть, рассматриваемая система описывается марковским случайным процессом с дискретными состояниями и непрерывным временем.

Из теории вероятности мы знаем, что функция плотности вероятности для n -го состояния ищется как совместная функция плотности для всей «предыстории» процесса прихода системы в это состояние: .

На практике марковские процессы в чистом виде не встречаются, но нередко приходится иметь дело с процессами, для которых влияние предыстории можно пренебречь. При изучении таких процессов можно применять марковские модели.

При переходе рассмотрения процесса как марковского аналитическое описание модели упрощается, так как полагаем, что состояние системы зависит только от одного предыдущего состояния: ![]() .

.

Цепи Маркова задаются набором четко определенных состояний: ![]() . По тому, когда и каким образом происходят «переходы», цепи Маркова делятся на дискретные, для которых время перехода из одного состояния в другое фиксировано, и определяется вероятностью этого перехода, и непрерывные, для которых состояния дискретны, время непрерывно и переходы из одного состояния в другое происходят в случайные, заранее не известные, моменты времени.

. По тому, когда и каким образом происходят «переходы», цепи Маркова делятся на дискретные, для которых время перехода из одного состояния в другое фиксировано, и определяется вероятностью этого перехода, и непрерывные, для которых состояния дискретны, время непрерывно и переходы из одного состояния в другое происходят в случайные, заранее не известные, моменты времени.

При анализе случайных процессов с дискретными состояниями удобно пользоваться геометрической схемой – так называемым графом состояний.

Определение. Граф – это совокупность множества вершин V и множество упорядоченных пар вершин A ={(a 1 a i) (a 2 a j) … }, элементы которого называются ребрами G (V ,A ).

Состояниям системы ставятся в соответствие вершины графа, а переходам из одного состояния в другое – верви с указанием «направления протекания» процесса.

На следующем примере рассмотрим методику исследования цепей Маркова с помощью размеченного графа состояний.

Пример №1. ТЭА техническая эксплуатация автомобиля.

Упрощенная модель ТЭА подразумевает наличие хотя бы четырех следующих состояний: S 1 – диагностика состояния автомобиля, S 2 – работа на линии (автомобиль исправен), S 3 – техническое обслуживание, S 4 – устранение неисправности (ремонт).

Соответствующий данной системе размеченный граф

![]() m

ij плотность вероятности перехода из состояния S i

в состояние S j

(S i

®S j

), где P ij

(Dt

) – вероятность того, что за промежуток времени Dt произойдет данный переход.

m

ij плотность вероятности перехода из состояния S i

в состояние S j

(S i

®S j

), где P ij

(Dt

) – вероятность того, что за промежуток времени Dt произойдет данный переход.

Для малых значений Dt справедливо следующее приближенное равенство .

Значения вероятностей переходов определяются из системы дифференциальных уравнений (Колмогорова) по следующим правилам:

1) каждой вершине ставится в соответствие соответствующее состояние, описываемое вероятностью нахождения системы в оном, поэтому количество состояний определяет количество уравнений в системе;

2) в левой части уравнения – производная вероятности соответствующего состояния;

3) в правой части столько слагаемых, сколько переходов (ветвей) в размеченном графе связано с данным состоянием;

4) каждый элемент правой части равен произведению плотности вероятности перехода на плотность вероятности того состояния, из которого осуществлялся переход;

5) в правой части со знаком «+» идут (складываются) элементы, описывающие попадание системы в данное состояние, и со знаком «-» (вычитаются) элементы, описывающие «выход» системы из данного состояния;

6) для упрощения «решаемости» в систему вводится нормирующее уравнение, описывающее полную группу событий: , где N-количество вершин в размеченном графе состояний.

|

Для рассматриваемого графа состояний получаем следующую систему уравнения:

Данная система уравнений будет легче решаема в случае, когда она описывает стационарный процесс работы исследуемой технической системы (обычно вхождение системы в стационарный режим функционирования занимает от 2-х до 4-х тактов).

На практике считаем, что предположение о стационарности функционирования системы правомерно, если время функционирования системы в целом на порядок выше, чем (20¸40)×тактов работы системы («последовательное» одинарное прохождение по ветвям графа).

Стационарность режима работы предполагает равенство нулю от производных по времени от вероятностей состояния, т.е. .

|

Система уравнений приводится к следующему виду:

и его решение уже не представляет особой сложности.

Система уравнений по Колмогорову позволяет решить задачу нахождения значений вероятностей для стационарного режима (финальных вероятностей) по известным плотностям вероятностей переходов по ветвям графа, равно как и обратную ей, т.е. нахождение плотностей вероятностей при заданных финальных вероятностях.

Пример №2.

Рассмотрим техническую систему S

, состоящую из двух параллельно работающих узлов (два поста на СТО, два заправочных автомата на АЗС). Будем полагать, что переходы системы из одного состояния в другое происходят мгновенно, в случайные моменты времени. Как только узел выходит из строя, он «мгновенно» поступает на ремонт и после приведения его в рабочее состояние он также «мгновенно» начинает эксплуатироваться.

Рассмотрим техническую систему S

, состоящую из двух параллельно работающих узлов (два поста на СТО, два заправочных автомата на АЗС). Будем полагать, что переходы системы из одного состояния в другое происходят мгновенно, в случайные моменты времени. Как только узел выходит из строя, он «мгновенно» поступает на ремонт и после приведения его в рабочее состояние он также «мгновенно» начинает эксплуатироваться.

Полагаем, что данная система полностью описывается всего четырьмя состояниями: S 0 – оба узла исправны; S 1 – первый узел ремонтируется, второй исправен; S 2 – второй узел ремонтируется, первый исправен; S 3 – ремонтируются оба узла.

l 1 , l 2 – плотность вероятности выхода из строя первого и второго поста, m 1 , m 2 – плотность вероятности восстановления первого и второго узла соответственно.

Составим систему дифференциальных уравнений по Колмогорову для вероятностей состояний данной системы.

Составим систему дифференциальных уравнений по Колмогорову для вероятностей состояний данной системы.

Чтобы решить уравнения Колмогорова и найти численные значения для вероятностей соответствующих состояний, необходимо задаться начальными условиями.

Будем полагать, что в начальный момент времени оба узла исследуемой системы исправны, система находится в состоянии S 0 , т.е. P 0 (t =0)=1, а все остальные начальные вероятности равны нулю: P 1 (0)=P 2 (0)=P 3 (0)=0.

Данная система уравнений легко решается в случае, если система функционирует в установившемся режиме и все процессы, протекающие в ней, стационарные.

Стационарность режима работы предполагает равенство нулю от производных по времени от вероятностей состояния, т.е., i

=1, 2, … , n

, , где n

– количество возможных состояний. А с учётом полной группы событий добавляется уравнение

Последнее, так называемое нормировочное условие, позволяет исключить из системы одно из уравнений…

Решим данную систему при следующих данных: l 1 =1, l 2 =2, m 1 =2, m 2 =3. Запишем систему без четвертого уравнения.

Решая их, получим: P 0 =0,4; P 1 =0,2; P 2 @0,27; P 3 @0,13.

Т.е. в стационарном режиме работы наша система в среднем 40% времени будет находиться в состоянии S 0 – оба узла исправны, и т.д..

Значения этих финальных вероятностей могут помочь оценить среднюю эффективность работы системы и загрузку ремонтных органов. Предположим, что система S в состоянии S 0 приносит доход 8 условных единиц (у.е.) в единицу времени, в состоянии S 1 3у.е., в S 2 5у.е., а в состоянии S 3 не приносит дохода.

МАРКОВСКИЙ ПРОЦЕСС

Процесс без последействия, - случайный процесс ,

эволюция к-рого после любого заданного значения временного параметра tне зависит от эволюции, предшествовавшей t,

при условии, что значение процесса в этот фиксировано (короче: "будущее" н "прошлое" процесса не зависят друг от друга при известном "настоящем").

Определяющее М. п. свойство принято наз. марковским; впервые оно было сформулировано А. А. Марковым . Однако уже в работе Л. Башелье можно усмотреть попытку трактовать броуновское как М. п., попытку, получившую обоснование после исследований Н. Винера (N. Wiener, 1923). Основы общей теории М. п. с непрерывным временем были заложены А. Н. Колмогоровым .

Марковское свойство. Имеются существенно отличающиеся друг от друга определения М. п. Одним из наиболее распространенных является следующее. Пусть на вероятностном пространстве задан случайный процесс со значениями из измеримого пространства где Т -

подмножество действительной оси Пусть N t

(соответственно N t

).есть s-алгебра в

порожденная величинами X(s).при

где

Другими словами, N t

(соответственно N t

) - это совокупность событий, связанных с эволюцией процесса до момента t(начиная с t).

Процесс X(t).наз.

марковским процессом, если (почти наверное) для всех выполняется марковское свойство:

или, что то же самое, если для любых

М. п., для к-рого Тсодержится в множестве натуральных чисел, наз. Маркова цепью

(впрочем, последний термин чаще всего ассоциируется со случаем не более чем счетного Е).

Если Тявляется интервалом в а Ене более чем счетно, М. п. наз. цепью Маркова с непрерывным временем. Примеры М. п. с непрерывным временем доставляются диффузионными процессами и процессами с независимыми приращениями, в том числе пуассоновским и винеровским.

В дальнейшем для определенности речь будет идти только о случае ![]() Формулы (1) и (2) дают ясную интерпретацию принципа независимости "прошлого" и "будущего" при известном "настоящем", но основанное на них определение М. п. оказалось недостаточно гибким в тех многочисленных ситуациях, когда приходится рассматривать не одно, а набор условий типа (1) или (2), отвечающих различным, хотя и согласованным определенным образом, мерам Такого рода соображения привели к принятию следующего определения (см. , ).

Формулы (1) и (2) дают ясную интерпретацию принципа независимости "прошлого" и "будущего" при известном "настоящем", но основанное на них определение М. п. оказалось недостаточно гибким в тех многочисленных ситуациях, когда приходится рассматривать не одно, а набор условий типа (1) или (2), отвечающих различным, хотя и согласованным определенным образом, мерам Такого рода соображения привели к принятию следующего определения (см. , ).

Пусть заданы:

а) где s-алгебра содержит все одноточечные множества в Е;

б) измеримое снабженное семейством s-алгебр таких, что если

в) (" ") x t =x

t

(w),

определяющая при любых измеримое отображение

г) для каждых и вероятностная мера на s-алгебре такая, что функция ![]() измерима относительно если и

измерима относительно если и

Набор наз. (необрывающимся) марковским процессом, заданным в если -почти наверное

каковы бы ни были Здесь - пространство элементарных событий, - фазовое пространство или пространство состояний, Р(s, x, t, В

) - переходная функция

или вероятность перехода процесса X(t).

Если Енаделено топологией, а - совокупность борелевских множеств в Е,

то принято говорить, что М. п. задан в Е.

Обычно в определение М. п. включают требование, чтобы и тогда истолковывается как вероятность при условии, что x s =x.

Возникает вопрос: всякую ли марковскую переходную функцию Р(s, x

; t, В

),

заданную в измеримом пространстве можно рассматривать как переходную функцию нек-рого М. п. Ответ положителен, если, напр., Еявляется сепарабельным локально компактным пространством, а - совокупностью борелевских множеств в Е.

Более того, пусть Е -

полное метрич. пространство и пусть

а - дополнение e-окрестности точки х. Тогда соответствующий М. п. можно считать непрерывным справа и имеющим пределы слева (т. е. таковыми можно выбрать его траектории). Существование же непрерывного М. п. обеспечивается условием при (см. , ). В теории М. п. основное внимание уделяется однородным (по времени) процессам. Соответствующее определение предполагает заданной систему объектов а) - г) с той разницей, что для фигурировавших в ее описании параметров sи u теперь допускается лишь значение 0. Упрощаются и обозначения:

Далее, постулируется однородность пространства W, т. е. требуется, чтобы для любых ![]() существовало такое что

существовало такое что ![]() (w) при Благодаря этому на s-алгебре N,

наименьшей из s-алгебр в W, содержащих любое событие вида

(w) при Благодаря этому на s-алгебре N,

наименьшей из s-алгебр в W, содержащих любое событие вида ![]() задаются операторы временного сдвига q t

, к-рые сохраняют операции объединения, пересечения и вычитания множеств и для к-рых

задаются операторы временного сдвига q t

, к-рые сохраняют операции объединения, пересечения и вычитания множеств и для к-рых

Набор наз. (необрывающимся) однородным марковским процессом, заданным в если -почти наверное

для Переходной функцией процесса X(t).считается Р(t, x, В

), причем, если нет специальных оговорок, дополнительно требуют, чтобы Полезно иметь в виду, что при проверке (4) достаточно рассматривать лишь множества вида где ![]() и что в (4) всегда F t

можно заменить s-алгеброй , равной пересечению пополнений F t

по всевозможным мерам Нередко в фиксируют вероятностную меру m ("начальное ") и рассматривают марковскую случайную функцию

и что в (4) всегда F t

можно заменить s-алгеброй , равной пересечению пополнений F t

по всевозможным мерам Нередко в фиксируют вероятностную меру m ("начальное ") и рассматривают марковскую случайную функцию ![]() где - мера на заданная равенством

где - мера на заданная равенством

М. п. наз. прогрессивно измеримым, если при каждом t>0 функция индуцирует измеримое в где есть s-алгебра

борелевских подмножеств в . Непрерывные справа М. п. прогрессивно измеримы. Существует способ сводить неоднородный случай к однородному (см. ), и в дальнейшем речь будет идти об однородных М. п.

Строго .

Пусть в измеримом пространстве задан М. п.

Функция наз. марковским моментом,

если ![]() для всех

При этом относят к семейству F t , если при (чаще всего F t интерпретируют как совокупность событий, связанных с эволюцией X(t).до момента т). Для полагают

для всех

При этом относят к семейству F t , если при (чаще всего F t интерпретируют как совокупность событий, связанных с эволюцией X(t).до момента т). Для полагают

Прогрессивно измеримый М. п. Xназ. строго марковским процессом (с. м. п.), если для любого марковского момента т и всех ![]() и соотношение

и соотношение

(строго марковское свойство) выполняется -почти наверное на множестве W t . При проверке (5) достаточно рассматривать лишь множества вида где ![]() в этом случае С. м. п. является, напр., любой непрерывный справа феллеровский М. п. в топологич. пространстве Е.

М. п. наз. феллеровским марковским процессом, если функция

в этом случае С. м. п. является, напр., любой непрерывный справа феллеровский М. п. в топологич. пространстве Е.

М. п. наз. феллеровским марковским процессом, если функция

непрерывна всякий раз, когда f непрерывна и ограничена.

В классе с. м. п. выделяются те или иные подклассы. Пусть марковская Р(t, x, В

),

заданная в метрическом локально компактном пространстве Е,

стохастически непрерывна:

для любой окрестности Uкаждой точки Тогда если операторы переводят в себя непрерывных и обращающихся в 0 в бесконечности функций, то функции Р(t, х, В

).отвечает стандартный М. п. X,

т. е. непрерывный справа с. м. п., для к-рого

Обрывающийся марковский процесс.

Нередко физич. системы целесообразно описывать с помощью необрывающегося М. п., но лишь на временном интервале случайной длины. Кроме того, даже простые преобразования М. п. могут привести к процессу с траекториями, заданными на случайном интервале (см. Функционал

от марковского процесса). Руководствуясь этими соображениями, вводят понятие обрывающегося М. п.

Пусть - однородный М. п. в фазовом пространстве имеющий переходную функцию ![]() и пусть существуют точка и функция

и пусть существуют точка и функция ![]() такие, что при и в противном случае (если нет специальных оговорок, считают ). Новая траектория x t

(w) задается лишь для ) посредством равенства

такие, что при и в противном случае (если нет специальных оговорок, считают ). Новая траектория x t

(w) задается лишь для ) посредством равенства ![]() a F t

определяется как в множестве

a F t

определяется как в множестве

Набор где ![]() наз. обрывающимся марковским процессом (о. м. п.), полученным из с помощью обрыва (или убивания) в момент z. Величина z наз. моментом обрыва, или временем жизни, о. м. п. Фазовым пространством нового процесса служит где есть след s-алгебры в Е.

Переходная функция о. м. п.- это сужение на множество

наз. обрывающимся марковским процессом (о. м. п.), полученным из с помощью обрыва (или убивания) в момент z. Величина z наз. моментом обрыва, или временем жизни, о. м. п. Фазовым пространством нового процесса служит где есть след s-алгебры в Е.

Переходная функция о. м. п.- это сужение на множество ![]() Процесс X(t).наз. строго марковским процессом, или стандартным марковским процессом, если соответствующим свойством обладает Необрывающийся М. п. можно рассматривать как о. м. п. с моментом обрыва Неоднородный о. м. п. определяется аналогичным образом. М.

Процесс X(t).наз. строго марковским процессом, или стандартным марковским процессом, если соответствующим свойством обладает Необрывающийся М. п. можно рассматривать как о. м. п. с моментом обрыва Неоднородный о. м. п. определяется аналогичным образом. М.

Марковские процессы и .

М. п. типа броуновского движения тесно связаны с дифференциальными уравнениями параболич. типа. Переходная р(s, x, t, у

).диффузионного процесса удовлетворяет при нек-рых дополнительных предположениях обратному и прямому дифференциальным уравнениям Колмогорова:

Функция р(s, x, t, у

).есть функция Грина уравнений (6) - (7), и первые известные способы построения диффузионных процессов были основаны на теоремах существования этой функции для дифференциальных уравнений (6) - (7). Для однородного по времени процесса L(s, x

) = L

(x).на гладких функциях совпадает с характеристич. оператором М. п. (см. Переходных операторов полугруппа

).

Математич. ожидания различных функционалов от диффузионных процессов служат решениями соответствующих краевых задач для дифференциального уравнения (1). Пусть - математич. ожидание по мере Тогда функция удовлетворяет при s

Аналогично, функция

удовлетворяет при s

и условию и 2 ( Т, x

) = 0.

Пусть тt - момент первого достижения границы дD

области

траекторией процесса

![]() Тогда при нек-рых условиях функция

Тогда при нек-рых условиях функция

удовлетворяет уравнению

и принимает значения ср на множестве

Решение 1-й краевой задачи для общего линейного параболич. уравнения 2-го порядка

при довольно общих предположениях может быть записано в виде

В случае, когда Lи функции с, f

не зависят от s,

аналогичное (9) представление возможно и для решения линейного эллиптич. уравнения. Точнее, функция

при нек-рых предположениях есть задачи

В случае, когдгг оператор Lвырождается (del b(s, х

) = 0

).или дD

недостаточно "хорошая", граничные значения могут и не приниматься функциями (9), (10) в отдельных точках или на целых множествах. Понятие регулярной граничной точки для оператора L

имеет вероятностную интерпретацию. В регулярных точках границы граничные значения достигаются функциями (9), (10). Решение задач (8), (11) позволяет изучать свойства соответствующих диффузионных процессов и функционалов от них.

Существуют методы построения М. п., не опирающиеся на построение решений уравнений (6), (7), напр. метод стохастических дифференциальных уравнений,

абсолютно непрерывная замена меры и др. Это обстоятельство вместе с формулами (9), (10) позволяет вероятностным путем строить и изучать свойства краевых задач для уравнения (8), а также свойства решении соответствующего эллиптич. уравнения.

Так как решение стохастического дифференциального уравнения нечувствительно к вырождению матрицы b(s, x

), то

вероятностные методы применялись для построения решений вырождающихся эллиптических и параболических дифференциальных уравнений. Распространение принципа усреднения Н. М. Крылова и Н. Н. Боголюбова на стохастические дифференциальные уравнения позволило с помощью (9) получить соответствующие результаты для эллиптических и параболических дифференциальных уравнений. Нек-рые трудные задачи исследования свойств решений уравнений такого типа с малым параметром при старшей производной оказалось возможным решить с помощью вероятностных соображений. Вероятностный смысл имеет и решение 2-й краевой задачи для уравнения (6). Постановка краевых задач для неограниченной области тесно связана с возвратностью соответствующего диффузионного процесса.

В случае однородного по времени процесса (Lне зависит от s) положительное решение уравнения с точностью до мультипликативной постоянной совпадает при нек-рых предположениях со стационарной плотностью распределения М. п. Вероятностные соображения оказываются полезными и при рассмотрении краевых задач для нелинейных параболич. уравнений. Р. 3. Хасьминский.

Лит. : Марков А. А., "Изв. физ.-мат. об-ва Казан. ун-та", 1906, т. 15, №4, с. 135-56; В а с h e l i е r L., "Ann. scient. Ecole norm, super.", 1900, v. 17, p. 21-86; Колмогоров А. Н., "Math. Ann.", 1931, Bd 104, S. 415- 458; рус. пер.-"Успехи матем. наук", 1938, в. 5, с. 5-41; Ч ж у н К а й - л а й, Однородные цепи Маркова, пер. с англ., М., 1964; Р е 1 1 е r W., "Ann. Math.", 1954, v. 60, p. 417-36; Д ы н к и н Е. Б., Ю ш к е в и ч А. А., "Теория вероятн. и ее примен.", 1956, т. 1, в. 1, с. 149-55; X а н т Дж.-А., Марковские процессы и потенциалы, пер. с англ., М., 1962; Д е л л а ш е р и К., Емкости и случайные процессы, пер. с франц., М., 1975; Д ы н к и н Е. В., Основания теории марковских процессов, М., 1959; его же, Марковские процессы, М., 1963; Г и х м а н И. И., С к о р о х о д А. В., Теория случайных процессов, т. 2, М., 1973; Фрейдлин М. И., в кн.: Итоги науки. Теория вероятностей, - важный специальный вид случайных процессов. Примером марковского процесса может служить распад радиоактивного вещества, где вероятность распада данного атома за малый промежуток времени не зависит от течения процесса в предшествующий период.… … Большой Энциклопедический словарь

Марковский процесс случайный процесс, эволюция которого после любого заданного значения временного параметра не зависит от эволюции, предшествовавшей, при условии, что значение процесса в этот момент фиксировано («будущее» процесса не… … Википедия

Марковский процесс - 36. Марковский процесс Примечания: 1. Условную плотность вероятности называют плотностью вероятности перехода из состояния xn 1в момент времени tn 1 в состояние хпв момент времени tn. Через нее выражаются плотности вероятностей произвольного… … Словарь-справочник терминов нормативно-технической документации

марковский процесс - Markovo procesas statusas T sritis automatika atitikmenys: angl. Markovprocess vok. Markovprozeß, m rus. марковский процесс, m; процесс Маркова, m pranc. processus markovien, m … Automatikos terminų žodynas

марковский процесс - Markovo vyksmas statusas T sritis fizika atitikmenys: angl. Markov process; Markovian process vok. Markow Prozeß, m; Markowscher Prozeß, m rus. марковский процесс, m; процесс Маркова, m pranc. processus de Markoff, m; processus marcovien, m;… … Fizikos terminų žodynas

Важный специальный вид случайных процессов. Примером Марковского процесса может служить распад радиоактивного вещества, где вероятность распада данного атома за малый промежуток времени не зависит от течения процесса в предшествующий период.… … Энциклопедический словарь

Важный специальный вид случайных процессов (См. Случайный процесс), имеющих большое значение в приложениях теории вероятностей к различным разделам естествознания и техники. Примером М. п. может служить распад радиоактивного вещества.… … Большая советская энциклопедия

Выдающееся открытие в области математики, сделанное в 1906 русским ученым А.А. Марковым.